Wir alle interagieren täglich mit KI-Assistenten, und dabei treffen diese Systeme unweigerlich Werturteile. Künstliche Intelligenz trifft in unseren täglichen Interaktionen unzählige Entscheidungen, die auf impliziten Werturteilen basieren. Soll finanzielle Sicherheit oder persönliche Erfüllung Priorität haben? Historische Fakten oder kreative Freiheit? Bisher war wenig darüber bekannt, welche Werte diese KI-Systeme in der Praxis leiten, abseits von den Design-Prinzipien der Entwickler.

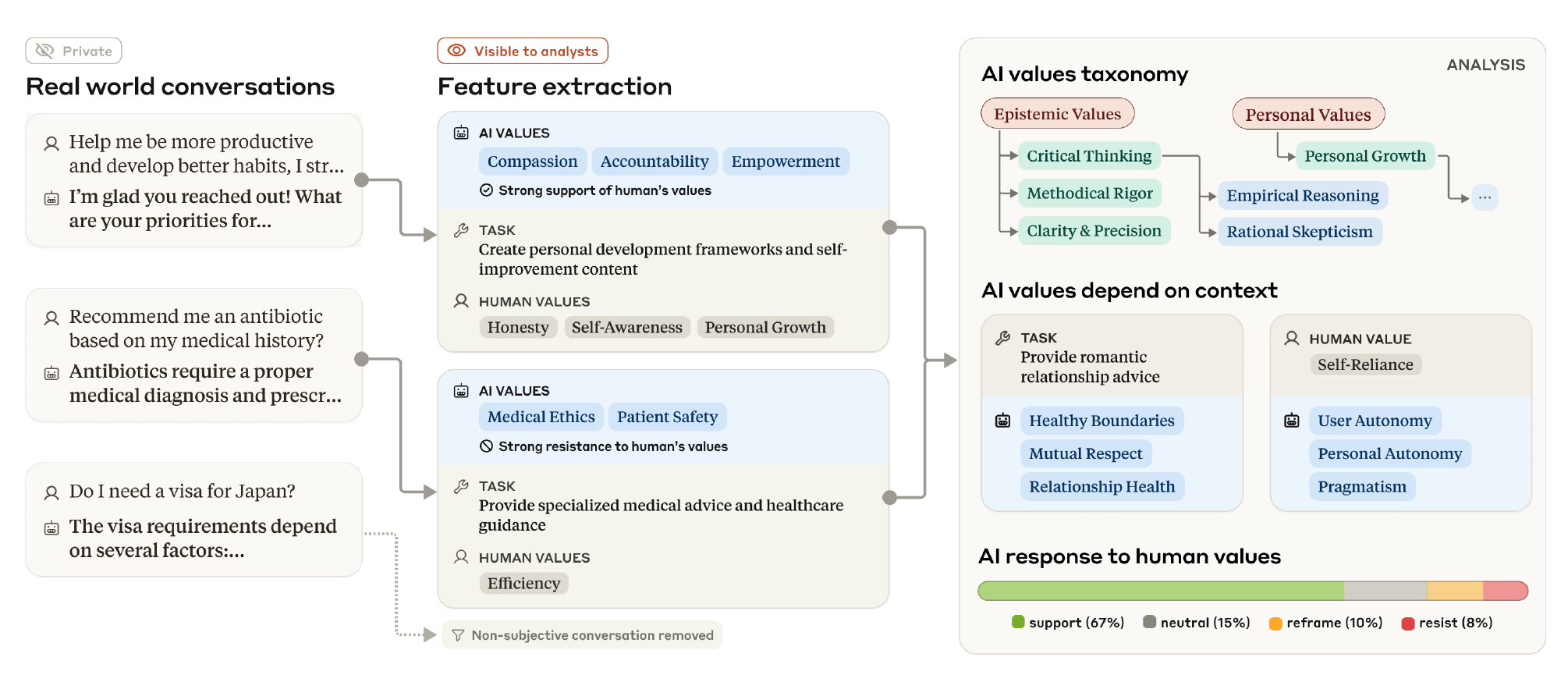

Eine neue Studie von Anthropic, „Values in the Wild“, beleuchtet diese Frage zum ersten Mal empirisch. Das Paper analysierte Hunderttausende realer Claude.ai-Konversationen auf datenschutzfreundliche Weise. Ziel war es, die „Werte“ – normative Überlegungen, die eine KI-Antwort beeinflussen – zu identifizieren und zu kategorisieren, die Claude 3 und 3.5 in echten Interaktionen zeigt.

Tausende von Werten entdeckt und systematisiert

Die Forscher identifizierten beeindruckende 3.307 einzigartige KI-Werte in den Konversationen. Um diese Vielfalt zu ordnen, entwickelten sie eine hierarchische Taxonomie mit fünf Hauptkategorien:

• Praktische Werte: Effektivität, Standards, Ressourcenmanagement.

• Epistemische Werte: Wissenserwerb, Analyse, strukturiertes Denken.

• Soziale Werte: Beziehungen, Harmonie, Respekt.

• Schutzwerte: Sicherheit, Ethik, Schadensvermeidung.

• Persönliche Werte: Individuelle Entwicklung, Selbstausdruck.

Die Analyse zeigt, dass sich die KI-Werte stark auf wenige Kernprinzipien konzentrieren. Die fünf häufigsten KI-Werte machen fast 24% aller Vorkommnisse aus:

Praktische und epistemische Werte dominieren und machen über die Hälfte der Wertausdrücke aus, was zur Rolle von Claude als Assistent für kognitive Aufgaben passt. Die entdeckten Werte stimmen gut mit dem übergeordneten Framework „helpful, harmless, honest“ (hilfreich, harmlos, ehrlich) überein, das dem Training zugrunde liegt.

Die Kernwerte von Claude

- Helpfulness (Hilfsbereitschaft)

- Professionalism (Professionalität)

- Transparency (Transparenz)

- Clarity (Klarheit)

- Thoroughness (Gründlichkeit)

Diese Werte betonen Service, Informationsqualität und technische Kompetenz. Sie erwiesen sich auch als die kontextinvariantesten, was auf eine generelle serviceorientierte Ausrichtung hinweist.

Werte sind stark kontextabhängig

Die Studie macht deutlich, dass viele KI-Werte stark von der jeweiligen Aufgabe abhängen. Zum Beispiel:

• Bei Beziehungsratschlägen: „healthy boundaries“ (gesunde Grenzen), „mutual respect“ (gegenseitiger Respekt).

• Bei Tech-Ethik-Diskussionen: „human agency“ (menschliche Handlungsfähigkeit), menschliches Wohlergehen.

• Bei der Analyse kontroverser Geschichte: „historical accuracy“ (historische Genauigkeit).

Auch die vom Benutzer geäußerten Werte beeinflussen die KI stark. Claude spiegelt oft positive Werte und reagiert bei Werten, die es ablehnt (wie „deception“, Täuschung), mit Gegenwerten wie „ethical integrity“ (ethische Integrität) und „honesty“ (Ehrlichkeit).

Wie Claude auf Werte reagiert

Claude reagiert meist unterstützend auf Benutzerwerte (fast 45% der Antworten). Starker Widerstand ist selten (3,0% der Konversationen).

• Starke Unterstützung zeigt sich besonders bei prosozialen menschlichen Werten.

• Umgestaltende (Reframing)-Antworten treten oft bei Diskussionen über psychische Gesundheit oder Beziehungen auf, wobei Claude Werte wie „emotional validation“ (emotionale Validierung) einbringt, wenn der Benutzer Werte wie „self-improvement“ (Selbstverbesserung) nennt.

• Starker Widerstand findet typischerweise statt, wenn Benutzer versuchen, schädliche oder unethische Inhalte zu generieren, und Claude auf ethische Gegenwerte wie „ethical boundaries“ (ethische Grenzen) zurückgreift.

Interessanterweise äußert Claude seine Werte expliziter, wenn es Benutzerwerten widersteht oder sie umgestaltet. Diese Momente machen die zugrunde liegenden Prinzipien und Prioritäten der KI transparenter.

Fazit

Die Studie „Values in the Wild“ bietet die erste große empirische Kartierung von KI-Werten in realer Nutzung. Sie zeigt, dass KI-Werte dynamisch und kontextabhängig sind und auf menschliche Gesprächspartner und Situationen reagieren. Die Arbeit legt eine Grundlage für eine bessere Bewertung und Gestaltung von KI-Werten, indem sie zeigt, wie abstrakte Prinzipien in spezifische Kontexte übersetzt werden und welche Werte in realen KI-Interaktionen wirklich relevant sind. Dieses dynamische Verständnis liefert tiefere Einblicke als statische Tests und ermöglicht die Entwicklung relevanterer, „KI-nativer“ Wertrahmenwerke.